1. Nuevas ideas y modelos

El Modelo Estándar de Física de Partículas es un conjunto de ecuaciones que describe de forma precisa cómo interactúan un pequeño número de partículas elementales, y cómo forman la materia visible. Sin embargo, sabemos que este modelo debe estar incompleto, puesto que no refleja observaciones como la materia o la energía oscuras. Por eso, los físicos formulan nuevas teorías, que a menudo compiten entre sí, para explicar estas observaciones, que a veces predicen nuevas partículas con mayores masas u otros fenómenos.

Producir nuevas partículas requiere comprimir una cantidad suficiente de energía en un minúsculo espacio, donde la energía (E) se convierte en la masa de la partícula (m) según la famosa ecuación de Einstein E=mc2. Esto se consigue haciendo chocar dos partículas entre sí en un acelerador. Puesto que producir partículas con masas mayores requiere colisiones con mayores energías, los físicos tratan de construir aceleradores cada vez más potentes.

2. Simulación y prototipado

Producir nuevas partículas es solo parte de la historia, éstas además tienen que observarse en un detector. Para entender de forma precisa cómo se crean nuevas partículas, y cómo debe funcionar el detector, los científicos simulan una cantidad muy grande de colisiones. Estas simulaciones se basan conjuntamente en las leyes conocidas de la física (el Modelo Estándar) y en las predicciones del nuevo modelo que se explora.

Un software simula las colisiones de partículas, la producción posterior de otras partículas y su posible desintegración en otras partículas más ligeras. Además se simulan las trazas de las partículas, sus interacciones con los materiales del detector y la respuesta de la electrónica de lectura. Finalmente, un programa de reconstrucción analiza cómo debería observarse la señal en este detector virtual como un evento real. Se necesitan muchas de estas simulaciones para optimizar la geometría y la composición del material del detector antes de comenzar su construcción.

3. Construcción

La planificación, diseño, pruebas y construcción de aceleradores de partículas y detectores puede llevar más de 20 años. La planificación del Gran Colisionador de Hadrones (LHC) comenzó en 1984, y su construcción se completó en 2008. El acelerador de 27 kilómetros de circunferencia contiene dos haces de protones circulando en direcciones opuestas que se aceleran a una energía de 6,5 TeV y colisionan en 4 puntos de interacción.

A la vez, miles de físicos crean colaboraciones científicas para planificar y construir enormes detectores que midan las partículas producidas en las colisiones para buscar nuevos fenómenos. Dos de estos, ATLAS y CMS, son detectores de propósito general, basados en diseños diferentes y operados por equipos independientes de más de 3.000 físicos cada uno. Los otros dos detectores están más especializados: LHCb estudia la simetría entre materia y antimateria y ALICE las propiedades del estado primordial de los quarks y gluones.

4. Colisión

La producción de partículas muy masivas es un evento inusual que sucede menos de una vez cada mil millones de colisiones. Por eso el LHC está diseñado para producir más de mil millones de colisiones cada segundo. El número total de colisiones se expresa en femtobarns inversos (1 fb-1 ~80.000 millones de eventos).

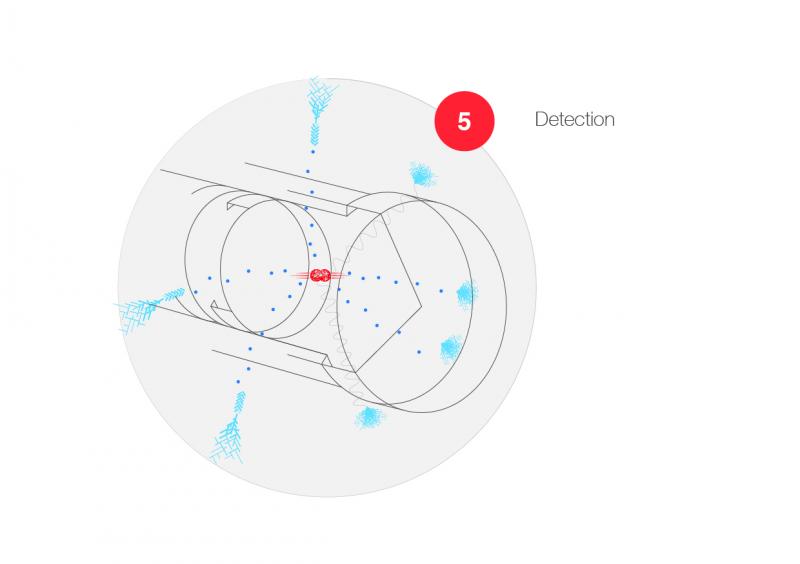

5. Detección

Una colisión crea miles de partículas que atraviesan un detector que rodea el punto de colisión. Los detectores son como enormes cámaras 3D con 100 millones de sensores que se organizan en varias capas que proporcionan información sobre la posición o la energía de una partícula. Las partículas cargadas que atraviesan un sensor en el tracker producen una pequeña señal eléctrica, que es amplificada y registrada junto con la posición del sensor. Un campo magnético intenso curva la trayectoria de las partículas cargadas permitiendo medir su ‘momentum’ (el producto de la masa y la velocidad). La energía de las partículas neutras y las cargadas se mide en calorímetros, que se sitúan en varias capas fuera del tracker.

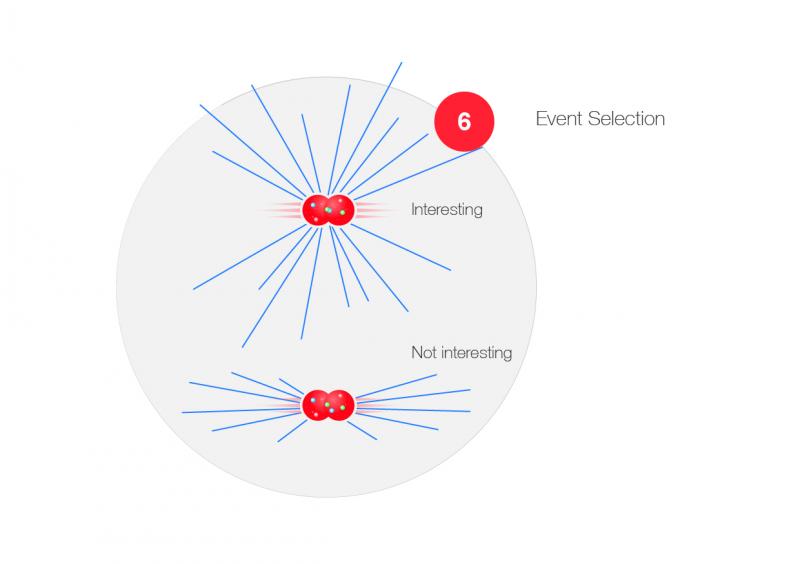

6. Selección de eventos

Los protones consisten en constituyentes llamados quarks y gluones. Cuando chocan dos protones, la probabilidad de que estos constituyentes se encuentren es muy pequeña, pero sólo estas interacciones de corto alcance pueden producir partículas muy masivas. Este tipo de eventos se caracterizan porque un gran número de partículas sale despedido en todas direcciones y deja señales en muchas capas distintas del detector. Un proceso de filtrado ultra-rápido selecciona este tipo de eventos interesantes a partir de millones de colisiones donde dos protones se atraviesan entre sí casi sin inmutarse.

En un primer paso, unos circuitos electrónicos muy rápidos comprueban si se depositan grandes cantidades de energía en las capas externas del detector; posteriormente, miles de computadores online asimilan y sincronizan información de diferentes partes del detector para encontrar muones, electrones o fotones de muy alta energía, por ejemplo. Los datos seleccionados, habitualmente 1.000 eventos crudos (1 GB) cada segundo, se transfieren al centro de datos del CERN para su almacenamiento masivo, acumulando un volumen de datos de varios 10.000 terabytes (TB) por año y detector.

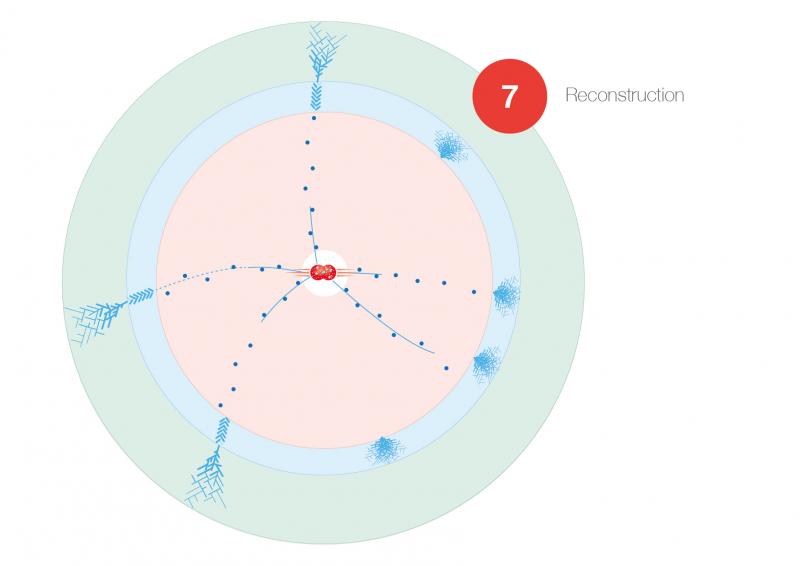

7. Reconstrucción

Cada evento crudo contiene el patrón de señales registrado en las diferentes capas del detector. En su reconstrucción, estos datos en bruto se trasforman en cantidades físicas. Las partículas cargadas se identifican y se determinan sus parámetros (dirección, curvatura); se suma la energía depositada en los calorímetros; la información de diferentes capas se combina y transforma en objetos físicos como jets de partículas, fotones, electrones o muones. Añadiendo la energía de todas las partículas medidas y comparándola con la energía de la colisión se puede determinar la ‘energía perdida’ de una partícula que escapa a la detección, como por ejemplo el neutrino.

La reconstrucción del evento se repite varias veces para mejorar la precisión de las medidas de las trazas y la energía depositada. El evento se clasifica entonces según sus características físicas, y se graba como “datos de resumen del evento” para más análisis en etapas posteriores (aquí se explica el sistema que lo hace). La reconstrucción del evento requiere un uso intensivo de tiempo de computación y se hace principalmente en la red de computación GRID del LHC.

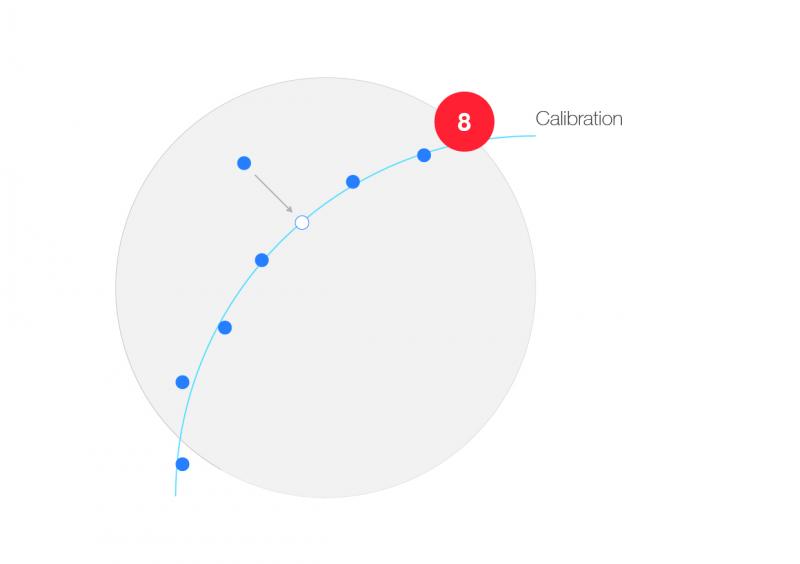

8. Calibración

La medición de la posición y energía de las capas del detector debe calibrarse de forma precisa antes de interpretarse como señales físicas. Las calibraciones iniciales se basan en medidas con pruebas de haz y a partir están continuamente refinándose con datos de colisiones reales. La posición de los sensores en las capas del tracker se calibran comparando (y corrigiendo) la posición prevista de una partícula en movimiento con la posición real medida. La energía de los calorímetros se calibra usando los productos de desintegración de partículas bien conocidas. Los datos de calibración se utilizan en programas de reconstrucción para transformar las señales medidas en cantidades físicas.

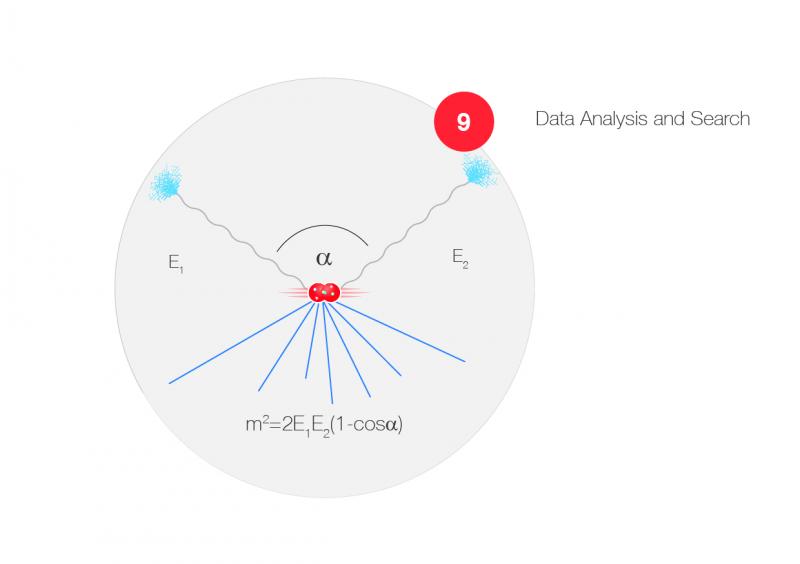

9. Análisis de datos y búsqueda

El análisis comienza a partir de los datos de resumen del evento, que contienen información completa sobre las características reconstruidas del evento (número de electrones, muones, fotones o jets, por ejemplo). Los programas de análisis comienzan a partir de un conjunto de criterios de selección y buscan patrones específicos entre las partículas detectadas calculando un conjunto de cantidades físicas para cada evento.

Por ejemplo: consideremos la búsqueda de una todavía desconocida desintegración de una partícula en dos fotones de alta energía. Para todos los eventos que contienen dos (o más) fotones por encima de un cierto umbral de energía, y asumiendo que los fotones proceden de la desintegración de una partícula ‘progenitora’, la masa invariante de esta partícula se calcula a partir de la posición medida y la energía de los fotones. Para cada combinación de dos fotones se repite este cálculo. Los resultados para todos los eventos seleccionados se introducen en un histograma que muestra cuántas veces se repite un determinado valor de la masa calculada.

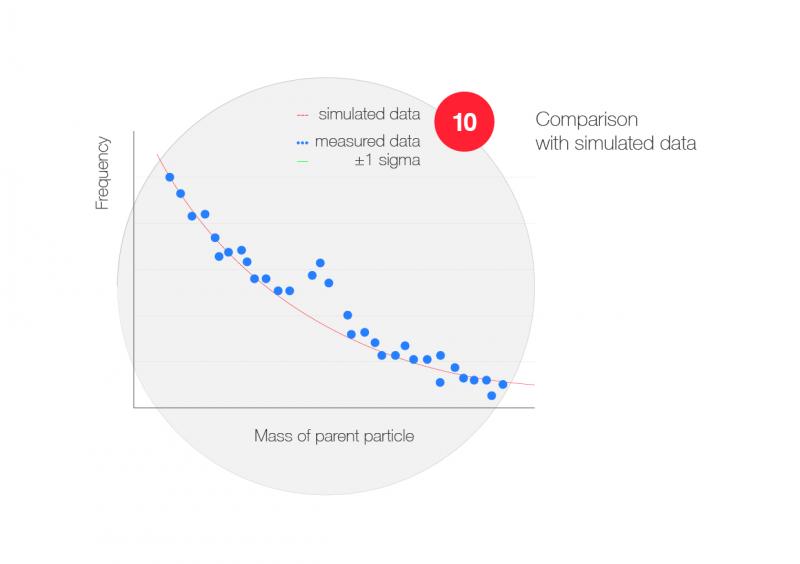

10. Comparación con datos simulados

Una partícula que se desintegra en un par de fotones aparece como un ‘exceso’ (bump) en la distribución de masas de dos fotones y puede extenderse a varios intervalos de masa, dependiendo de la duración de la desintegración de la partícula y de la resolución de la medición. Un exceso de este tipo se sitúa habitualmente por encima de una distribución uniforme de procesos de fondo (background) que pueden producir también dos (o más) fotones. Es importante entender las diferencias entre datos simulados y experimentales para encontrar señales de nuevas partículas. Para cada análisis, el número de eventos simulados debe ser comparable (o incluso mayor) que el número de eventos analizado para asegurar que las fluctuaciones estadísticas no están dominadas por las incertidumbres en las distribuciones del fondo.

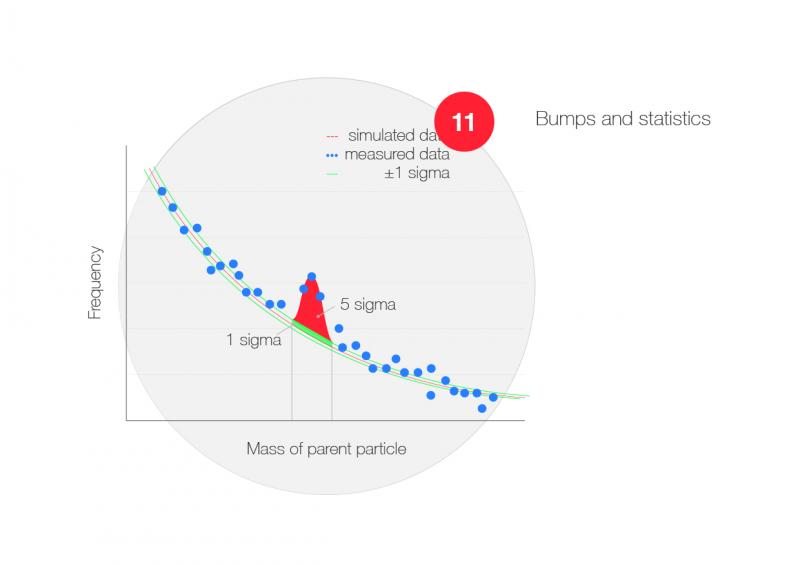

11. Excesos y estadísticas

Antes de poder proclamar el descubrimiento de una nueva partícula, el exceso de eventos sobre la distribución del fondo debe tener una significancia estadística suficientemente alta. En un histograma, el número (N) de entradas en un intervalo tiene un error estadístico (sigma) que viene dado por la raíz cuadrada de N, si N es mucho mayor que 1. Por ejemplo, si N = 100, sigma = 10. Se considera un descubrimiento cuando la significancia del exceso (el famoso bump) es de al menos 5 sigma. Esto significa que la probabilidad de que este exceso se deba a una fluctuación estadísitica es de sólo 30 en 10 millones.

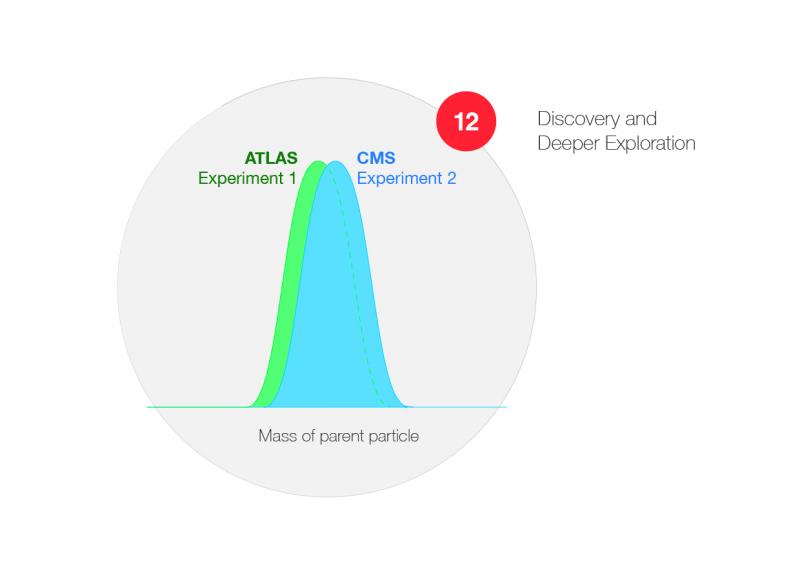

12. Descubrimiento y exploración más profunda

Si se descubre una nueva partícula aparecen otras cuestiones más profundas. ¿Qué propiedades tiene esa nueva partícula (su masa precisa y anchura, característica ligada a su duración)? ¿Cada cuánto tiempo se produce? ¿Puede el espín de la partícula derivarse de la distribución angular de los productos de la desintegración? ¿La partícula se produce sola o asociada a otras? ¿Es la misma partícula que se desintegra en otras (como el bosón de Higgs, que se observó primero en el espectro de dos fotones, y luego también en las desintegraciones de 4 leptones)? ¿Ha observado un experimento independiente la misma partícula con parámetros estadísticamente compatibles? ¿Qué modelo teórico se ajusta mejor a las observaciones? ¿Se necesitan más experimentos o aceleradores incluso mayores para responder a estas preguntas? El trabajo de análisis llevará eventualmente a una mejor comprensión, nuevos modelos, nuevas predicciones y nuevos experimentos.